¿Por qué MCP está cambiando la integración de IA en proyectos reales?

En pleno auge de la inteligencia artificial, los modelos de lenguaje (LLMs) como Claude o GPT están limitados por el acceso a datos actualizados y la dificultad de integrarse a múltiples sistemas empresariales de forma segura y escalable. Aquí es donde el Model Context Protocol (MCP) irrumpe como una solución revolucionaria: un protocolo abierto y universal que simplifica la conexión entre IA y tus sistemas, cuidando en todo momento de la seguridad y la eficiencia.

¿Qué hace único al Model Context Protocol?

MCP se asemeja a un hub central: conecta LLMs con bases de datos, APIs internas, repositorios de código y herramientas cloud, de una sola vez y siguiendo estándares robustos. A diferencia de las integraciones personalizadas y frágiles, MCP propone una arquitectura con roles definidos:

- Servidores MCP: Exponen datos o herramientas (ej. consultas SQL, endpoints cloud, acceso a archivos).

- Clientes MCP: Modelos de IA capaces de consumir esos recursos, decidir acciones o alimentar flotillas de bots inteligentes.

La magia está en la estandarización: no más soluciones ad-hoc, sino una puerta única y segura para dotar a tu IA de contexto en tiempo real y ejecutar tareas en cualquier stack.

Ejemplo #1: Chatbots con acceso a bases de datos internas

¿Te imaginas un chatbot de soporte que accede en tiempo real a una base de datos corporativa para dar respuestas precisas? MCP lo hace posible al exponer, mediante servidores MCP, recursos como registros SQL o documentos clave. Con una definición schema-first (JSON), controlas qué datos pueden ser consultados y bajo qué permisos, evitando que el bot acceda a información sensible o realice operaciones peligrosas.

- Flujo: El LLM (cliente MCP) solicita, mediante una URI, un recurso de la base de datos. El servidor MCP filtra y valida la consulta según el usuario.

- Seguridad: Los accesos son auditables, el tráfico cifrado (TLS), y cada acción requiere autenticación (API keys u OAuth).

Ejemplo #2: Herramientas de generación de código asistidas por IA

Piensa en integrar un asistente de código (tipo copiloto) a tu editor, pero con acceso solo a los repositorios y branches permitidos, y con restricciones granulares. Con MCP, expones recursos delimitados (archivos, history particular) y herramientas seguras (crear pull requests, ejecutar tests) a través de un servidor MCP.

- Beneficio: Reduces el riesgo de fuga de información o ejecución de comandos peligrosos.

- Interoperabilidad: Facilita plugins para editores como VS Code o flujos de CI/CD.

Ejemplo #3: Automatización cloud y DevOps supervisada por IA

¿Quién no quiere automatizar incidentes, monitorear logs o provisionar recursos sin intermediarios humanos todo el tiempo? MCP permite orquestar estos escenarios, mediando entre la IA y APIs cloud (AWS, GCP, Azure, sistemas internos), siempre con validación previa y políticas de permisos declarativas.

- Workflow típico: El LLM detecta un error en logs, consulta un recurso MCP, invoca una herramienta (ej.: escalar un pod), y genera un reporte.

- Mitigación de riesgos: Uso de anotaciones tipo

destructiveHintpara operaciones críticas, aprobación humana cuando el modelo intente acciones destructivas.

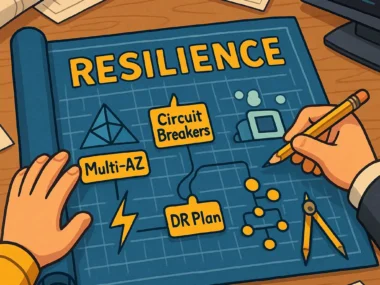

Profundizando en el blindaje de seguridad de MCP

1. Autenticación robusta

MCP soporta OAuth2 y API keys, permitiendo la integración con SSO empresarial o sistemas de gestión de identidades. Cada solicitud puede trazarse hasta un usuario o cliente concreto, minimizando riesgos de acceso inapropiado.

2. Cifrado e integridad del canal

Las comunicaciones emplean TLS/HTTPS de punta a punta. Los recursos (desde archivos a comandos de API) deben ser validados y sanitizados antes de exponerse. La especificación requiere que incluso logs y recursos binarios sigan protocolos de seguridad (validación de MIME, limpieza de rutas).

3. Gestión granular de permisos

Una de las características más potentes: los permisos de acceso se pueden definir por recurso, por usuario y/o por tipo de operación (lectura, escritura, ejecución). Esto es vital para equipos DevOps, donde no todo el mundo debe poder modificar infraestructura, pero sí consultar estados o logs.

- Soporte para

role-based access control (RBAC), permitiendo políticas complejas como «solo lectura para datos de monitoreo», «aprobación previa para deployments», etc. - Audit logs nativos, facilitando cumplimiento con GDPR, SOC2 y otros estándares requeridos por empresas y organizaciones reguladas.

¿Por dónde empezar con MCP? Recursos y herramientas

- Documentación oficial MCP: https://modelcontextprotocol.io/

- GitHub oficial: https://github.com/modelcontextprotocol

- Quickstart Guide: https://modelcontextprotocol.io/quickstart

- Artículo de referencia técnica: https://coffeebytes.dev/es/comprende-el-model-context-protocol-mcp-de-una-vez-por-todas/

Reflexión y visión de futuro: ¿Hacia dónde va MCP?

La adopción temprana de MCP por parte de empresas disruptivas sugiere que los próximos asistentes de IA actuarán no solo como consejeros sino como ejecutores directos de tareas críticas en la nube y el entorno DevOps. Su enfoque modular, abierto y auditable lo convierte en candidato natural para entornos donde la automatización inteligente no puede sacrificar la seguridad ni la trazabilidad.

Para cloud engineers, DevOps y entusiastas tech moto: El futuro de la integración IA no pasa por reinventar la rueda, sino por impulsar estándares como MCP, donde todo queda registrado, controlado… y listo para acelerar.

¿Te interesa llevar tu IA a otro nivel?

Cuéntanos en los comentarios qué casos de uso te gustaría ver aplicados con MCP, comparte este artículo con tu equipo o sígueme en X (Twitter) y LinkedIn para más experimentos en cloud, DevOps y automatización tech. ¡Dale un boost seguro y escalable a tus proyectos de IA!