Las 5 herramientas de TIME 2025 que sí mueven la aguja para desarrolladores

Cada año, TIME publica su lista de inventos más influyentes. Es un escaparate enorme (300 innovaciones en 2025) y, honestamente, fácil de perderse. Por eso hice el filtrado con lentes de dev web/backend: elegí 5 herramientas que pueden mejorar de forma tangible nuestro flujo de trabajo en código, CI/CD, IA y prototipado.

Metodología express de selección

- Impacto directo en velocidad de desarrollo, calidad o costo.

- Integración con stacks reales (APIs, SDKs, ROS2, contenedores, MLOps).

- Privacidad/seguridad (opción local-first u opciones empresariales).

- Maturidad y señales de adopción/comunidad.

Con eso en mente, vamos al grano.

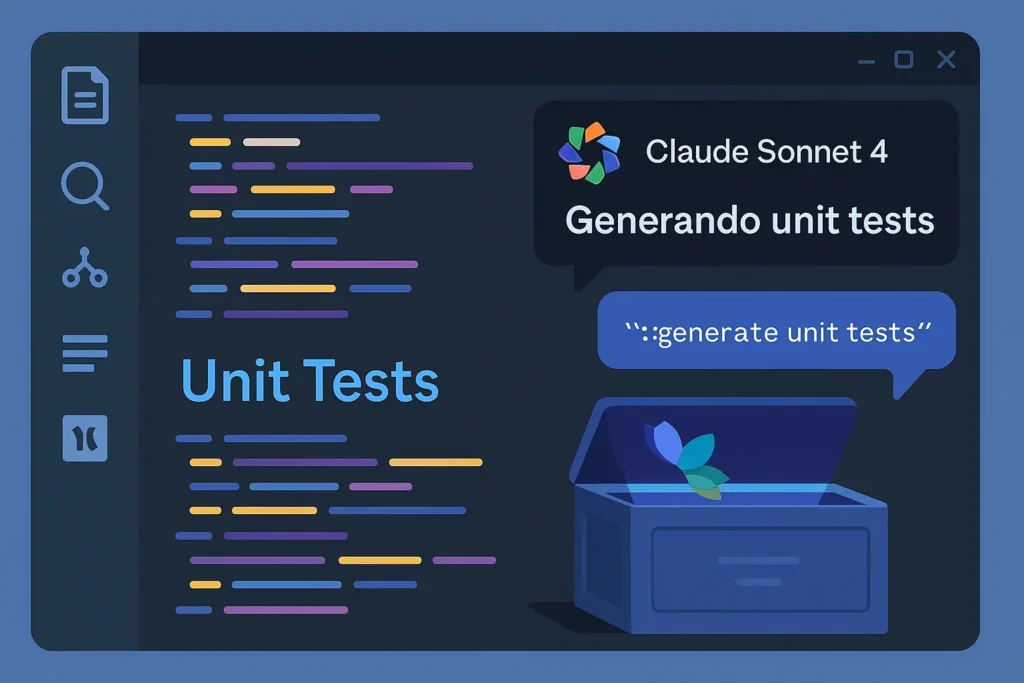

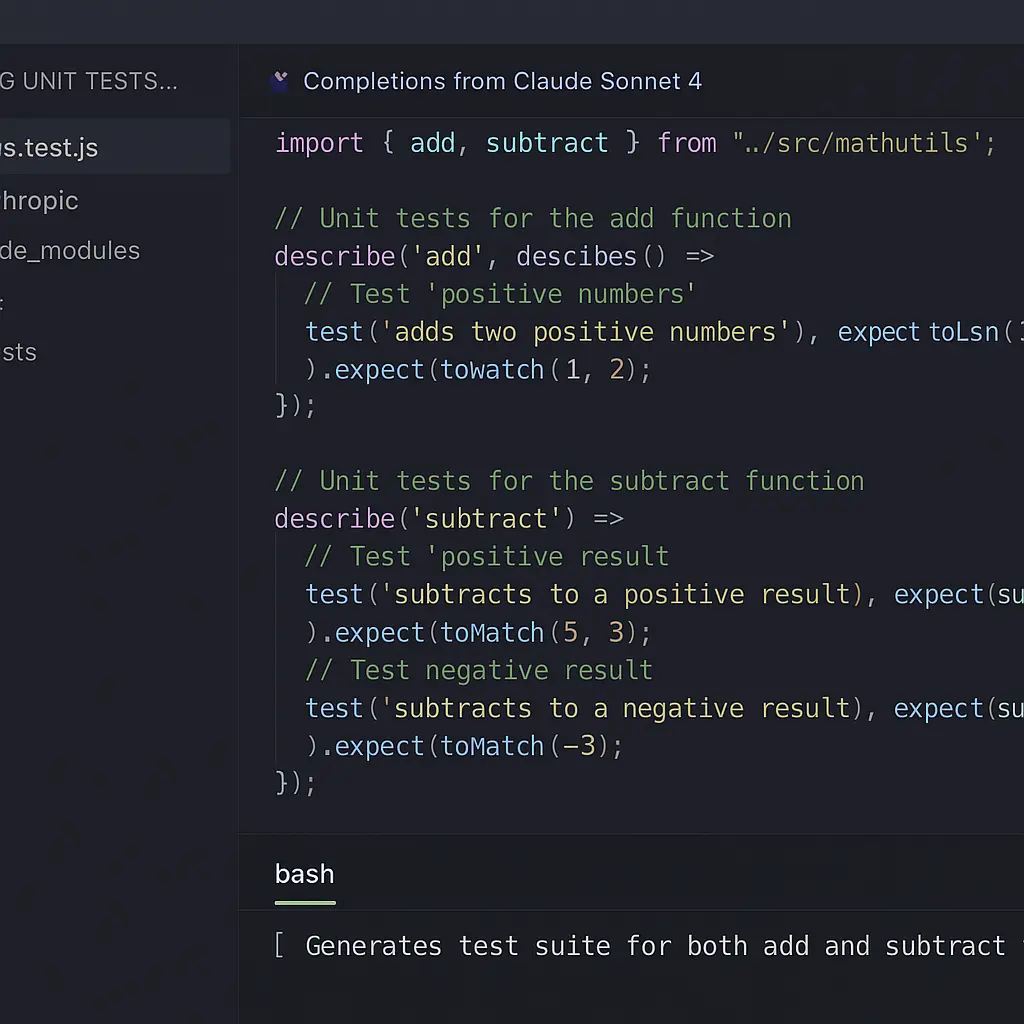

1) Anthropic Claude Sonnet 4: IA más segura para coding y documentación

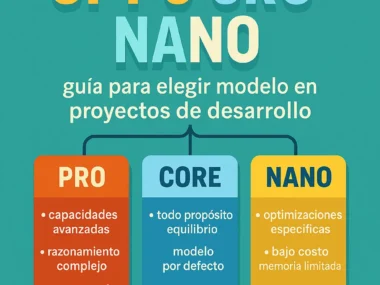

Qué es: Un modelo generativo de lenguaje de última generación con foco en seguridad y alineamiento. En 2025 fue destacado por su balance entre razonamiento, velocidad y controles de uso responsable.

Por qué importa a devs: Ayuda a escribir código, explicar arquitecturas, generar pruebas y convertir especificaciones en plantillas listas para implementar. Su política de seguridad y filtros reduce la probabilidad de respuestas peligrosas en entornos empresariales.

Stack y puntos técnicos: APIs de tool-use, funciones estructuradas, manejo robusto de contexto, y opciones para prompt caching y RAG. Integra bien con pipelines en Node.js, Python y backends serverless.

Impacto en tu workflow:

- Kickstart de features con esqueletos bien comentados.

- Documentación y ADRs más rápidas y consistentes.

- Pair programming 24/7 para desbloquear dudas de framework.

Riesgos y límites: Alucinaciones bajo requisitos ambiguos y dependencia excesiva del asistente. Mitiga con tests-first, validación humana y guardrails.

Cómo probar hoy: Crea un asistente con instrucciones de proyecto, adjunta tu guía de estilo y CI, y pídele generar pruebas para un módulo legado. Mide cobertura + defectos post-merge.

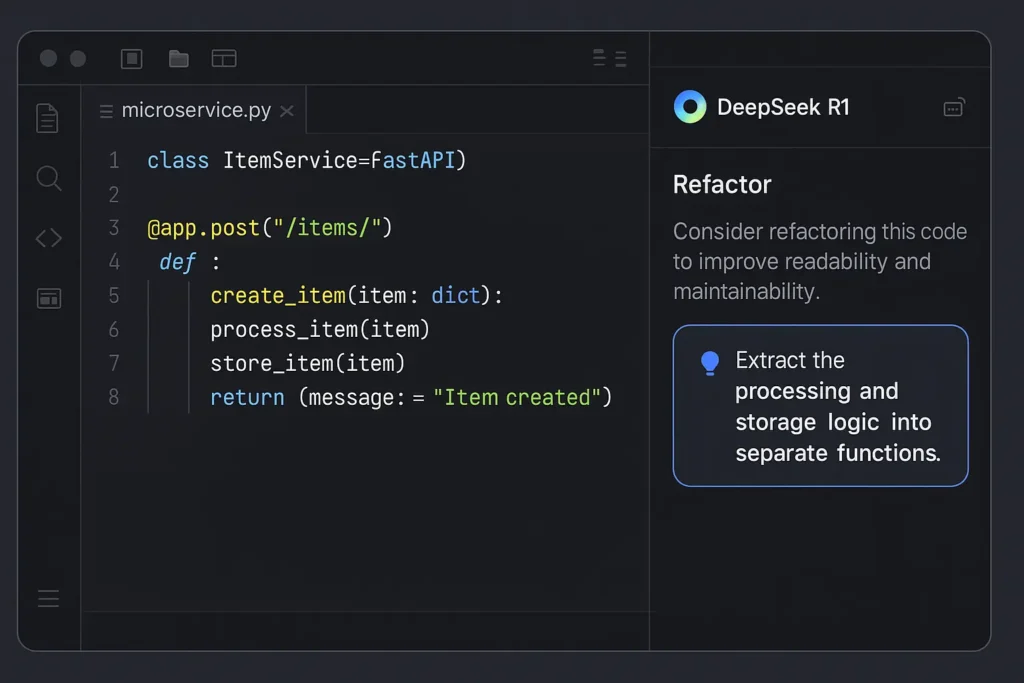

2) DeepSeek R1: razonamiento económico y self-hosting posible

Qué es: Un modelo de IA orientado a razonamiento y costos competitivos. Ha ganado tracción por su desempeño en tareas complejas y por opciones de despliegue más abiertas.

Por qué importa a devs: Permite automatizar refactors, migraciones entre frameworks y análisis de stack traces. Útil si buscas equilibrio entre performance y coste para equipos que iteran rápido.

Stack y puntos técnicos: APIs compatibles con ecosistema LLM actual, buen encaje para function calling y agentes livianos. Opciones de self-hosting o BYO-infra para datos sensibles.

Impacto en tu workflow:

- Refactor guiado por pruebas a menor costo.

- Reescritura de módulos con sugerencias de patrones.

- Asistentes de soporte que leen logs y recomiendan mitigaciones.

Riesgos y límites: Requiere curar prompts y diseñar checkers automáticos (lint + unit + security). La gobernanza del modelo y las actualizaciones deben auditarse.

Cómo probar hoy: Implementa un agente que reciba errores de producción (con datos anonimizados), proponga parches y dispare PRs etiquetados para revisión humana.

3) NVIDIA DGX Spark: supercomputación de IA en escritorio (sin depender siempre de la nube)

Qué es: Una estación de trabajo tipo supercomputadora pensada para entrenamiento y fine-tuning local. TIME la destaca como puente entre research y equipos de producto que necesitan tiempos de iteración cortos.

Por qué importa a devs: Para backend/ML engineers, habilita prototipos de IA en on-prem con datos sensibles, reduce cuenta de cloud y acelera experimentación (latencia cero a la idea).

Stack y puntos técnicos: CUDA/cuDNN, contenedores con NGC, Kubernetes local para MLOps, soporte para marcos como PyTorch, TensorRT, Triton Inference Server y orquestación reproducible.

Impacto en tu workflow:

- Entrenamientos cortos y fine-tuning de modelos propietarios cerca del código.

- Benchmarks de inferencia antes de pasar a GPU cloud.

- Entorno controlado para cumplimiento y auditorías.

Riesgos y límites: TCO inicial alto; necesitas disciplina en capacity planning, monitoreo térmico y upgrades. La estrategia híbrida (local + nube) es clave.

Cómo probar hoy: Monta un pipeline de fine-tuning con datasets internos, integra experiment tracking (MLflow/Weights & Biases) y compara costo/tiempo vs. tu cuenta cloud.

4) Unitree R1: humanoide accesible como plataforma de desarrollo (ROS2 out-of-the-box)

Qué es: Un robot humanoide ágil, con SDK y ecosistema activo. Destacado por TIME por llevar la robótica dinámica a un público más amplio.

Por qué importa a devs: Si trabajas en robotics + AI, es un banco de pruebas para percepción, planificación y control, con ROS2 y simulación listos para empezar. Ideal para POCs de automatización, logística o interacción humano-robot.

Stack y puntos técnicos: ROS2, sensores IMU/LiDAR/cámaras, control de movimientos de 26+ DOF, soporte para aprendizaje por refuerzo y vision pipelines. Integración con simulators (Gazebo/Isaac) y APIs para estados y comandos.

Impacto en tu workflow:

- Prototipos de habilidades robóticas con CI en simulación.

- Validación de algoritmos de percepción con datasets reales.

- Integración de LLMs para instrucción en lenguaje natural.

Riesgos y límites: Seguridad física y failsafes obligatorios; deuda de mantenimiento mecánico y de firmware; latency budget para cerrar loops de control.

Cómo probar hoy: Desarrolla primero en simulador, integra controladores, luego haz bring-up gradual: percepción, localización, y task skills con políticas de emergencia.

5) AirPods Pro 3 (con IA de traducción y métricas): productividad silenciosa para devs remotos

Qué es: La tercera generación de los in-ear de Apple llegó con mejoras de cancelación activa, voice isolation, biometría y traducción casi en tiempo real. TIME los resalta por utilidad transversal.

Por qué importa a devs: Menos fricción en reuniones globales, focus mode real en espacios ruidosos y feedback de salud que ayuda a sostener sesiones largas sin fatiga auditiva.

Stack y puntos técnicos: Integración con iOS/macOS, APIs de accesibilidad y dictado, chips con DSP optimizado y modelos on-device para tareas de voz.

Impacto en tu workflow:

- Standups bilingües sin pausas por barrera idiomática.

- Revisiones de PR en cafés/aviones sin perder contexto.

- Mejor escucha en pair programming remoto.

Riesgos y límites: En entornos multiplataforma no Apple perderás parte de la magia. Traducción no siempre perfecta; valida términos técnicos.

Cómo probar hoy: Configura perfiles de sonido por actividad (reunión, foco, descanso). En reuniones mixtas, activa traducción y comparte acuerdos por escrito post-llamada.

Cómo encajan en un stack web/backend real

- Descubrimiento: emplea Claude o DeepSeek para mapear requisitos en historias y criterios de aceptación.

- Entrega: genera esqueletos de servicios, contratos OpenAPI y pruebas. Ejecuta lint + unit + SAST automáticos.

- IA local: una DGX Spark para prototipos privados de RAG sobre tu documentación y repos internos.

- Experiencia: AirPods para foco/traducción; agiliza comunicación con clientes y squads globales.

- Exploración: Unitree R1 si tu roadmap toca robótica/automatización; CI en simulación + pruebas controladas.

Riesgos globales y antídotos prácticos

- Sesgo de automatización: no delegues decisiones de arquitectura. Usa IA como copiloto, no piloto.

- Seguridad de datos: preferir opciones BYOK/self-host para información sensible. Enmascara datos en prompts.

- Costos: define budgets por proyecto y kill-switches de consumo.

- Compliance: registra artefactos y decisiones. Auditoría continua para modelos y pipelines.

Plan 30-60-90 días para implementar sin drama

- 0-30: pilotos con Claude/DeepSeek en un repositorio acotado. Métricas: tiempo de PR, defectos por KLOC, cobertura.

- 31-60: MLOps local con DGX Spark: RAG interno y fine-tuning ligero. Política de datos y roles de acceso.

- 61-90: Escala de uso de IA a 2-3 squads; define guardrails y buenas prácticas. Si aplica, PoC de robótica con Unitree en simulación y demos mensuales.

Checklist para decidir qué adoptar

- ¿Acelera un cuello de botella medible (PR lead time, MTTR, defect density)?

- ¿Puedes operarlo con tu equipo actual sin deuda técnica descontrolada?

- ¿Cumple con tu política de datos y requisitos de auditoría?

- ¿Existe plan de salida o alternativa equivalente para evitar lock-in?

Conclusión: más allá del hype, 2025 consolidó herramientas que acortan la distancia entre idea y entrega. Si priorizas adopciones con métricas claras y guardrails, puedes ganar velocidad sin sacrificar calidad ni seguridad.

¿Qué herramienta piensas probar primero? Me interesa leer tus experiencias: comenta, comparte el post con tu equipo y suscríbete para próximos análisis prácticos.